Hace algunos años, nadie hubiese imaginado que el internet produciría un inmenso volumen de data que seria analizada y procesada para mejorar el conocimiento y la toma de decisiones en las empresas.

Pero, lo cierto, es que día tras día, la información en formato digital se duplica a una velocidad inimaginable, lo cual, por supuesto, genera una cantidad de datos bastante alta.

Al tener una cantidad de data tan alta, es necesario recurrir al denominado proceso del Big Data o también conocido como inteligencia de datos, para poder procesarlos y analizarlos.

Sin embargo, para profundizar en esta disciplina es necesario conocer y comprender sus términos más básicos y técnicos.

Es por ello, que en Velogig, hemos desarrollado un glosario de términos para que estés mucho más familiarizado con el fascinante mundo del Big Data:

Ciencia de datos (Data Science)

La Data Science abarca metodología científica, procesos y sistemas para extraer conocimiento o tener un entendimiento mucho más profundo de los datos, a fin de resolver con éxito los problemas analíticos que pudiesen presentarse.

Analista de datos

Es aquella persona que está capacitada para recopilar y analizar la data mediante técnicas estadísticas que le permitirán conocer la estructura de los datos para interpretarlos y establecer estrategias de valor.

Algoritmo

El algoritmo es un pilar fundamental en la era digital y permite encontrar y expresar ese algo que buscamos, en el caso del Big Data, busca patrones y relaciones entre variables.

Cabe destacar, que los algoritmos son creados con el único fin de automatizar el procesamiento de la gran cantidad de datos que se genera diariamente.

Analítica predictiva

Tal como indica su nombre, se trata de una ciencia que se encarga de predecir el futuro de una empresa mediante su data histórica y, tiene como finalidad mejorar la planificación y optimizar los resultados, a través de la implementación de técnicas basadas en algoritmos estadísticos como el modelado predictivo.

Analítica de negocio

Es una técnica orientada a la exploración de grandes volúmenes de datos con un enfoque en el análisis estadístico.

Esta técnica se emplea para obtener información congruente, actual y estructurada, que ayude a definir las decisiones de negocios para tener una ventaja competitiva frente a otras empresas.

Inteligencia de negocios (Business Intelligence)

Permite que los datos obtenidos sean transformados en información estructurada, mediante un conjunto de metodologías que actúan como frente estratégico ante el proceso de toma de decisiones en un negocio.

Analytics

Es el procedimiento de obtención, procesamiento y análisis de los datos para convertirlos en insights.

Machine Learning

Es una de las tantas ramas de la inteligencia artificial, la cual tiene como foco principal ‘’enseñar’’ a las máquinas a solucionar diversas tareas mediante los datos, con el fin de automatizar la resolución de un problema sin realizar una programación previa y explicita de los pasos a seguir para lograrlo.

Deep Learning

Pertenece al mismo conjunto del Machine Learning pero, además de aprender a resolver tareas a partir de la data, es capaz de aprender a representar los datos para llegar a la solución.

Por otra parte, requiere que los datos se encuentren muy bien estructurados para poder tener un óptimo funcionamiento.

Lo interesante de esto último, es que esta característica permite al Deep Learning abarcar problemas con un nivel de solución alto para una máquina, tales como, la visión artificial y el reconocimiento de voz.

Blaze

Es una interfaz que permite la consulta de datos provenientes de diferentes sistemas de almacenamiento.

También, es conocido como una librería de una de las herramientas de Big Data más usada, Python; y ayuda a almacenar, describir, consultar y procesar datos.

Clase binaria

La clase binaria corresponde a una técnica matemática, la cual permite la resolución de los modelos de programación no lineal.

Small Data

A diferencia del Big Data, el Small Data, se enfoca en analizar pequeñas cantidades de datos.

C++

Es un lenguaje de programación híbrido que fue desarrollado con la intención de extender el lenguaje de programación C con mecanismos que posibilitan la manipulación de objetos.

Este lenguaje de programación tiene la particularidad de redefinir operadores y permite crear nuevos tipos que se comporten como tipos fundamentales.

Minería de datos o Data Mining

La minería de datos tiene como objetivo principal sustraer información de un determinado conjunto de datos para posteriormente transformarla en una estructura comprensible para su uso.

Para emplearla, es necesario, utilizar métodos de inteligencia artificial, aprendizaje automático, estadística y sistemas de bases de datos.

SQL (Structured Query Language)

Es un lenguaje estandarizado que se utiliza en programación y tiene como función principal, definir, administrar, manipular y recuperar los datos de una base de datos relacionales.

Sus principales características son el manejo del álgebra y del cálculo relacional.

NoSQL (Not Only SQL)

Representa a los sistemas de gestión de bases de datos. Su objetivo principal es solventar los problemas de rendimiento del Big Data, puesto que las bases de datos relacionales no están diseñadas para solucionarlos.

Weka (Waikato Environment for Knowledge Analysis)

Es una plataforma de software para el aprendizaje automático y la minería de datos.

Weka, contiene una colección algoritmos para análisis de datos, modelos predictivos y herramientas de visualización, los cuales están sujetos a un interfaz gráfico de usuario para acceder de manera sencilla a todas sus funciones.

Python

Es un lenguaje de programación multiparadigma, el cual permite a los programadores manejar diversos estilos de programación, entre los cuales se encuentran la programación orientada a objetos, la programación imperativa y la programación funcional.

Entre sus características más resaltantes se encuentra la resolución dinámica de nombres o también conocido como enlace dinámico de métodos, el cual enlaza un método y un nombre de variable, mientras el programa se encuentre en ejecución.

También, se pueden escribir nuevos módulos de manera muy sencilla en C o C++.

Internet de las cosas (IoT)

Se refiere a la conexión digital que tienen los objetos cotidianos de internet entre sí.

En otras palabras, son elementos que tienen identificadores únicos y son capaces de transferir datos mediante una red, sin precisar de interacción humana con el fin de recopilar datos para la posterior verificación de los patrones de uso del cliente.

Perl (Practical Extracting and Reporting Language)

Es un lenguaje de scripting, el cual está conformado por los lenguajes C, Bourne Shell, AWK y en menor grado de otros lenguajes de programación.

Su función principal es extraer información de ficheros de texto para poder generar informes, también ha sido utilizado para limpiar y depurar datos.

Data Lake

El Data Lake no es más que un depósito que permite almacenar una extensa cantidad de datos en bruto, los cuales permanecen allí hasta que sea necesario usarlos.

Es importante mencionar que un data lake utiliza una arquitectura plana para almacenar la data, es decir, no almacena los datos en ficheros o carpetas como lo hace un data warehouse.

Cuando un elemento se encuentra en el data lake, se le adjudica un identificador único y se etiqueta con un conjunto de etiquetas de metadatos extendidas.

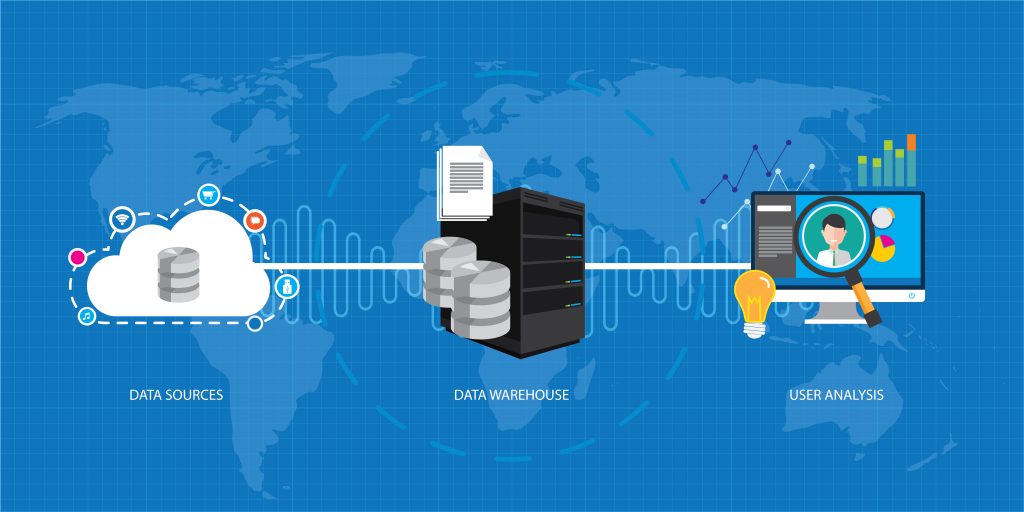

Data Warehouse

Al igual que el Data Lake, el Data Warehouse es un almacén de datos e información, el cual guarda aquellos datos que son netamente necesarios para realizar análisis e informes.

Esta herramienta, además de almacenar la información depurada para su uso posterior, también permite reservar aquellas consultas que le realizaron con anterioridad, así como también los análisis que ya se han creado.

UIMA (Unstructured Information Management Applications)

Es una arquitectura de software que fue creada para el desarrollo, descubrimiento, composición y expansión de analíticas multimodales para poder analizar un conjunto de información no estructurada con el fin de develar datos significativos para el usuario final.

Lingüística computacional (Computational Linguistics)

Es una disciplina de la Inteligencia Artificial que se encarga describir el funcionamiento del lenguaje natural para que pueda ser transformado en programas ejecutables en una computadora.

La Lingüística Computacional es un trabajo en conjunto, entre un lingüista e ingenieros especialistas, los cuales deben transformar la data existente de voz y texto, en un lenguaje estructurado que permita que la inteligencia artificial entienda y procese para poder generar una respuesta.

Bosque aleatorio (Random Forest)

Es una composición de árboles predictores en la que cada árbol es dependiente de los valores de un vector aleatorio probado de manera independiente.

El objetivo de este método es conseguir un análisis mucho más predictivo en comparación con otros algoritmos de aprendizaje.

Cloud Computing

Es un cúmulo de principios y enfoques que permiten a un usuario mediante una red, acceder a infraestructura informática, servicios, plataformas, datos y aplicaciones provenientes de la nube.

Cabe mencionar que las nubes son grupos de recursos que se administran a través de un software de gestión y automatización para facilitar el acceso a los usuarios, según lo soliciten.

Para utilizar un cloud computing, es necesario contar con sistemas operativos específicos, software de virtualización y herramientas de automatización y gestión.

Sentiment Analytics (Análisis de Sentimientos o Minería de Opinión)

Se trata de la unión entre el procesamiento de lenguaje natural, el análisis de texto y la lingüística computacional para determinar la actitud de un interlocutor o usuario con respecto a un tema específico, sea escrito o hablado.

Si te apasiona el Big Data y te quieres convertir en un experto, asegúrate de aprender, entender y emplear a la perfección estos conceptos básicos.

16 mayo, 2019

16 mayo, 2019

Deja una respuesta